Il linguaggio umano, una capacità fondamentale, è orchestrato da processi neurali complessi che hanno confuso i ricercatori per anni. La complicata interazione tra le regioni neurali responsabili del controllo dei movimenti precisi dei muscoli della bocca, della mascella e della lingua e quelle coinvolte nel processo di feedback uditivo della propria voce ha da sempre rappresentato un rompicapo stimolante. Svelare questo mistero è essenziale per progredire nello sviluppo di protesi vocali per coloro che hanno perso la capacità di parlare.

Un team di ricercatori della New York University (NYU), guidato da Adeen Flinker, Professore Associato di Ingegneria Biomedica presso la Tandon School of Engineering della NYU e in Neurologia presso la Grossman School of Medicine della NYU, e Yao Wang, Professore di Ingegneria Biomedica e Ingegneria Elettrica ed Informatica presso la Tandon School of Engineering della NYU, oltre a essere membro del NYU WIRELESS, sta facendo progressi significativi nel decifrare l’enigma neurale della parola. Il loro obiettivo è creare una tecnologia di ricostruzione vocale che offre speranza a coloro che hanno perso la capacità di parlare.

Il team di ricerca della NYU ha sfruttato il potenziale di intricate reti neurali per ricreare la parola da registrazioni cerebrali, gettando luce sui meccanismi neurali alla base del linguaggio umano. Le loro scoperte rivoluzionarie sono state pubblicate nelle Proceedings of the National Academy of Sciences (PNAS).

La produzione del linguaggio umano coinvolge processi neurali complessi, tra cui il controllo anticipatorio dei comandi motori e l’elaborazione del feedback inerente alla propria produzione di discorso. Questi processi richiedono l’attivazione simultanea di molte reti neurali, rendendo difficile discernere l’opportunità e la portata del coinvolgimento corticale nel controllo motorio rispetto all’elaborazione sensoriale durante la produzione del linguaggio.

Nella loro recente ricerca, il team della NYU ha con successo separato questi processi intricati. Hanno impiegato un’innovativa architettura di apprendimento profondo su registrazioni neurochirurgiche umane e utilizzato un sintetizzatore vocale differenziabile basato su regole per decodificare i parametri del linguaggio dai segnali corticali. Le architetture delle reti neurali implementate possono distinguere tra convoluzioni temporali causali (utilizzando segnali neurali attuali e passati per decodificare il linguaggio corrente), anticausali (utilizzando segnali neurali attuali e futuri) o una combinazione di entrambi (non causali), consentendo loro di analizzare meticolosamente i contributi del controllo anticipatorio e del feedback nella produzione del linguaggio.

Il Dott. Flinker spiega:

Questo approccio ci ha permesso di separare i processi di elaborazione dei segnali neurali di controllo anticipatorio e di feedback che avvengono simultaneamente durante la produzione del linguaggio e la percezione del feedback della nostra stessa voce.”

Incredibilmente, questo innovativo approccio non solo ha decodificato parametri del linguaggio interpretabili, ma ha anche svelato dettagli sui campi recettivi temporali delle regioni corticali coinvolte nella produzione del linguaggio. Contrariamente alle idee dominanti che separano le reti corticali di feedback e di controllo anticipatorio, le analisi dei ricercatori hanno rivelato un’architettura complessa di elaborazione mista di feedback e di controllo anticipatorio che coinvolge le cortecce frontale e temporale. Questa prospettiva innovativa, unita a un eccezionale rendimento nella decodificazione del linguaggio, rappresenta un notevole avanzamento nella comprensione dei meccanismi neurali complessi che stanno alla base della produzione del linguaggio.

Il team di ricerca della NYU ha utilizzato questa nuova comprensione per guidare lo sviluppo di protesi in grado di leggere l’attività cerebrale e tradurla direttamente in linguaggio. Ciò che distingue il loro prototipo da altri è la capacità di ricreare la voce del paziente, anche con un insieme minimo di registrazioni. Questa tecnologia offre un aiuto vitale ai pazienti che hanno perso la voce, consentendo loro di non solo riacquistarla, ma di riprodurla fedelmente. Ciò è reso possibile da una rete neurale profonda che tiene conto di uno spazio uditivo latente e può essere addestrata con solo pochi campioni della voce di un individuo, come un video di YouTube o una registrazione Zoom.

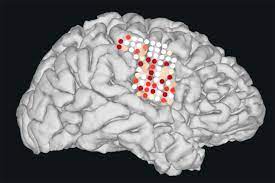

Per raccogliere i dati essenziali, i ricercatori si sono rivolti a pazienti affetti da epilessia refrattaria, una condizione che non risponde alla terapia farmacologica. Questi pazienti avevano un insieme di elettrodi EEG subdurali impiantati nel cervello per una settimana al fine di monitorare la loro condizione e hanno acconsentito all’uso di ulteriori 64 elettrodi più piccoli intercalati tra quelli clinici standard. Questi preziosi contributi hanno gettato le basi per questa ricerca innovativa.

Questo studio è stato reso possibile grazie ai finanziamenti della National Science Foundation (NSF) e degli Istituti Nazionali di Salute (NIH). Successivamente, i ricercatori hanno ottenuto finanziamenti aggiuntivi per approfondire la comprensione della neurobiologia del linguaggio e sviluppare nuove applicazioni cliniche per il linguaggio e il discorso. Questi finanziamenti sono stati concessi congiuntamente dal programma di Ricerca Collaborativa in Neuroscienze Computazionali della NSF e dal Programma di Ingegneria per Disabilità e Riabilitazione (DARE).

In un mondo in cui la voce e la comunicazione rivestono un’importanza cruciale, questa ricerca rivoluzionaria apre la strada a protesi del linguaggio migliorate e a una comunicazione potenziata per le persone affette da disturbi del linguaggio. Il lavoro pionieristico del team di ricerca della NYU promette di rivoluzionare il campo della ricostruzione del linguaggio e di portare nuova speranza a coloro che hanno perso la capacità di parlare.